前回、エクスペリメンタルビルドで公開された「Redshiftコンポーネントの使いドコロ」をお伝えしましたが、今回は実際にフローを作って、つないでみたいと思います。

まず、この3つのフローを作成してみます。

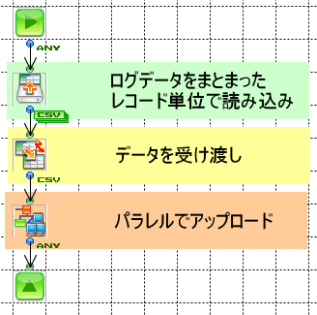

さっそく1つ目の「S3にパラレルで転送するフロー」です。

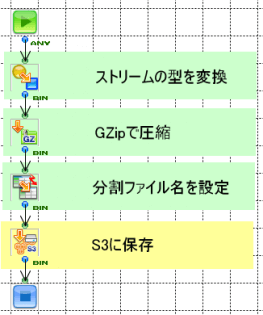

フローが2つありますが、パラレルで転送するので、1つずつ動くものはサブフローとして定義します。

今回は登録データとしてシステムのログファイルを使いました。1ファイルに何万行とあるファイルを分割で読み込み、指定した行数単位でパラレル実行しS3に保存しています。

この際、GZipで圧縮することで転送量を大幅に軽減することができます。

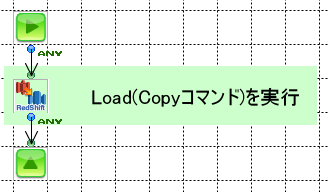

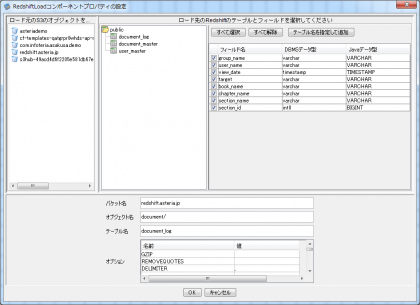

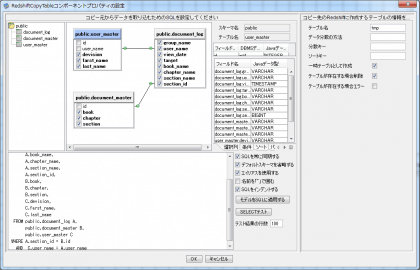

次にS3からRedshiftにコピーするフローを作成しますが、コンポーネントは1つだけです。

こちらは1つ目のフローの後にすぐ呼び出しても問題ありません。

コンポーネントではコピー元であるS3のバケットとオブジェクトの指定、さらにコピー先のRedshiftのテーブルを画面で設定することができます。

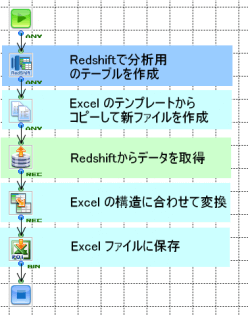

最後にExcelへの出力を行うフローです。

最初のコンポーネントでRedshiftに分析用のテーブルを作成しています。

これは画面で設定したSQLの結果を元に、新たなテーブルを作れるコンポーネントです。

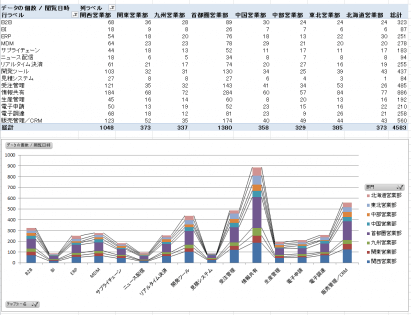

出力されるExcelは、予めデータを入れるとグラフやピポッドテーブルが出るようにテンプレートを用意しておきます。

なので、ASTERIA Warpではデータを差し込むだけです。

今回は上記のような、地域別やカテゴリ別などにまとめたグラフや表を出力するようにしてみました。

いかがでしたでしょうか?

さて、ここまでの流れを動画でもご紹介していますので、こちらも合わせてご覧ください!

↓ ↓ ↓

データのアップロードから簡易分析まで、Javaなどのプログラミング開発を一切することなく、このようなことができてしまいます。

更に、できたExcelレポートを添付メールで配信したり、この処理自体を毎週実行するなどといったことも可能です!

「でも開発工数が、、」「うちには技術者居ないから・・・」などとお悩みの方、まずは1ヶ月無料評価版で試してみるのはいかがでしょうか?

ASTERIA Warpシリーズ担当のシニアプロダクトマネージャー。ホワイトペーパーの執筆のほか、開発経験を活かしたASTERIA Warpを使ったデモ作成等を実施。

![MDMコラム[入門編]第1回:マスターデータ管理(MDM)とは?メリットや進め方、導入事例をご紹介!](https://www.asteria.com/jp/wp-content/uploads/2013/01/warpblog_88671186_title01.png)

Related Posts

ASTERIA Warp製品の技術情報やTips、また情報交換の場として「ADNフォーラム」をご用意しています。

アステリア製品デベロッパー同士をつなげ、技術情報の共有やちょっとしたの疑問解決の場とすることを目的としたコミュニティです。